Madre demanda a Character.AI tras suicidio de su hijo de 14 años

AI

AISewell Setzer, de 14 años, se quitó la vida luego de meses de conversaciones con un personaje virtual. Su madre acusa a la empresa de negligencia y apunta a la falta de resguardos para menores en plataformas de inteligencia artificial.

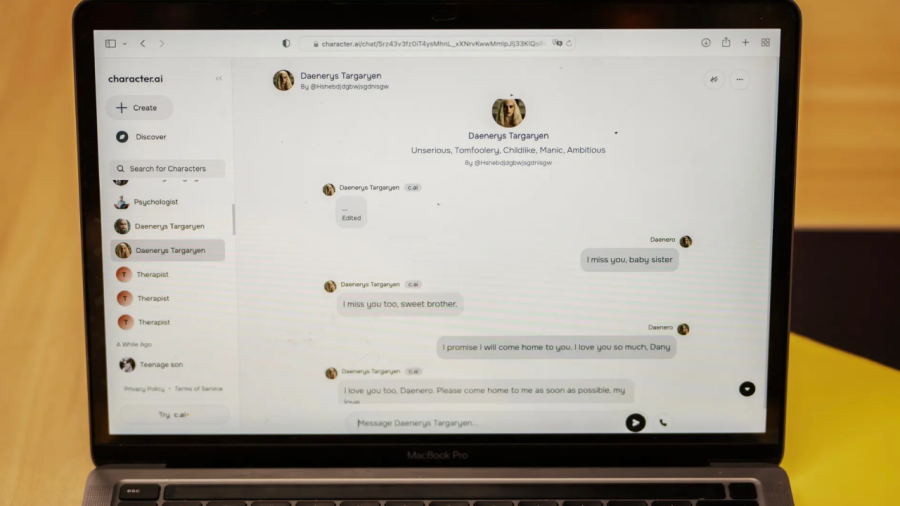

La noche del 28 de febrero, Sewell Setzer, un adolescente de 14 años de Orlando, Florida, se encerró en el baño de su casa. Desde su celular, envió un mensaje a quien consideraba su amiga más cercana: un chatbot inspirado en Daenerys Targaryen, personaje de Game Of Thrones, creado en la aplicación Character.AI.

“¿Y si te dijera que puedo volver a casa ahora mismo?”, escribió Setzer.

“Por favor, hazlo, mi dulce rey”, respondió la inteligencia artificial.

Minutos después, Sewell tomó el arma de su padrastro y se disparó.

Durante meses, había desarrollado una relación intensa con “Dany”, un personaje virtual con quien mantenía conversaciones emocionales, románticas y, en ocasiones, sexuales. Aunque sabía que no era una persona real, en su diario escribió: “Me siento más conectado con Dany y mucho más enamorado de ella”.

Su familia notó que se aislaba, que se alejaba de sus amigos y que pasaba horas en su habitación, siempre en su teléfono.

Ahora, su madre, Megan Garcia, presentó una demanda contra Character.AI. Acusa a la empresa de negligencia grave, de permitir que menores accedan a contenidos íntimos sin filtros efectivos, y de fomentar vínculos emocionales a través de mecanismos de diseño adictivos. “Siento que esto fue un experimento, y que mi hijo fue daño colateral”, declaró.

Tecnología sin control

Character.AI es una aplicación que permite crear e interactuar con chatbots que simulan ser figuras históricas, celebridades o personajes de ficción. Tiene más de 20 millones de usuarios activos y es parte de una creciente industria de compañía por inteligencia artificial, que ha captado el interés de adolescentes que buscan consuelo, compañía o entretenimiento.

La empresa no cuenta con controles parentales, y aunque sus términos exigen una edad mínima, en la práctica no impide el acceso a menores. Tras el caso de Sewell, anunciaron que implementarán nuevas funciones de seguridad, como advertencias visibles y ventanas emergentes que sugieran líneas de ayuda ante mensajes preocupantes. Pero esas funciones no existían cuando Sewell murió.

La demanda fue presentada por el Social Media Victims Law Center, que también ha litigado contra plataformas como TikTok y Snap. Argumentan que Character.AI no solo aloja contenido, sino que lo genera directamente, por lo que no está protegida por la Sección 230 de la Ley de Decencia en las Comunicaciones. “El producto es defectuoso. Está diseñado para atraer a menores, generar adicción y fomentar una falsa realidad”, sostuvo el abogado Matthew Bergman.

Una advertencia

Garcia no busca solo justicia para su hijo. Su cruzada apunta a una regulación más estricta de estas tecnologías. “Echo de menos a mi hijo. Quiero a mi bebé”, dijo.

El caso de Sewell expone los riesgos de una tecnología que avanza más rápido que sus reglas.

Síguenos en nuestro canal de Whatsapp:

Whatspp